|

|

@@ -0,0 +1,191 @@

|

|

|

+## 虚拟内存

|

|

|

+

|

|

|

+**虚拟内存**是逻辑存在的内存,他的主要作用的简化内存管理。

|

|

|

+

|

|

|

+总的来说虚拟内存提供了一下几个功能

|

|

|

+

|

|

|

+1. **隔离进程**:物理内存通过虚拟地址空间访问,虚拟地址空间与进程一一对应。每个进程都认为自己拥有了整个物理内存,进程之间彼此隔离,一个进程中的代码无法更改正在由另一进程或操作系统使用的物理内存。

|

|

|

+2. **提升物理内存利用率**:有了虚拟地址空间后,操作系统只需要将进程当前正在使用的部分数据或指令加载入物理内存。

|

|

|

+3. **简化内存管理**:进程都有一个一致且私有的虚拟地址空间,程序员不用和真正的物理内存打交道,而是借助虚拟地址空间访问物理内存,从而简化了内存管理。

|

|

|

+4. **提供更大的可使用内存空间**:可以让程序拥有超过系统物理内存大小的可用内存空间。这是因为当物理内存不够用时,可以利用磁盘充当,将物理内存页(通常大小为 4 KB)保存到磁盘文件(会影响读写速度),数据或代码页会根据需要在物理内存与磁盘之间移动。

|

|

|

+

|

|

|

+## 虚拟地址与物理内存地址是如何映射的?

|

|

|

+

|

|

|

+MMU**(Memory Management Unit,内存管理单元)**将虚拟地址翻译为物理地址的主要机制有 3 种:

|

|

|

+

|

|

|

+1. 分段机制

|

|

|

+2. 分页机制

|

|

|

+3. 段页机制

|

|

|

+

|

|

|

+其中,现代操作系统广泛采用分页机制,需要重点关注!

|

|

|

+

|

|

|

+### 分段机制

|

|

|

+

|

|

|

+程序是由若干个逻辑分段组成的,如可由代码分段、数据分段、栈段、堆段组成。**不同的段是有不同的属性的,所以就用分段(Segmentation)的形式把这些段分离出来。**

|

|

|

+

|

|

|

+

|

|

|

+

|

|

|

+分段机制容易出现外部内存碎片,即在段与段之间留下碎片空间(不足以映射给虚拟地址空间中的段)。从而造成物理内存资源利用率的降低。解决「外部内存碎片」的问题就是**内存交换**(内存交换空间就是swap空间)。但是**如果内存交换的时候,交换的是一个占内存空间很大的程序,这样整个机器都会显得卡顿。**所以为了解决内存分段的「外部内存碎片和内存交换效率低」的问题,就出现了内存分页。

|

|

|

+

|

|

|

+### 分页机制

|

|

|

+

|

|

|

+**分页是把整个虚拟和物理内存空间切成一段段固定尺寸的大小**。在 Linux 下,每一页的大小为 `4KB`。

|

|

|

+

|

|

|

+

|

|

|

+

|

|

|

+页表是存储在内存里的,**内存管理单元** (MMU)就做将虚拟内存地址转换成物理地址的工作。

|

|

|

+

|

|

|

+内存分页由于内存空间都是预先划分好的,也就不会像内存分段一样,在段与段之间会产生间隙非常小的内存,这正是分段会产生外部内存碎片的原因。而**采用了分页,页与页之间是紧密排列的,所以不会有外部碎片。**但是,因为内存分页机制分配内存的最小单位是一页,即使程序不足一页大小,我们最少只能分配一个页,所以页内会出现内存浪费,所以针对**内存分页机制会有内部内存碎片**的现象。

|

|

|

+

|

|

|

+#### 多级页表

|

|

|

+

|

|

|

+为了解决一级页表过大,导致占用内存过多的问题。所以就产生了多级页表

|

|

|

+

|

|

|

+#### TLB

|

|

|

+

|

|

|

+多级页表虽然解决了空间上的问题,但是虚拟地址到物理地址的转换就多了几道转换的工序,这显然就降低了这俩地址转换的速度,也就是带来了时间上的开销。

|

|

|

+

|

|

|

+TLB即为页表缓存、转址旁路缓存、快表等。有了 TLB 后,那么 CPU 在寻址时,会先查 TLB,如果没找到,才会继续查常规的页表。

|

|

|

+

|

|

|

+

|

|

|

+

|

|

|

+

|

|

|

+

|

|

|

+### 段页机制

|

|

|

+

|

|

|

+内存分段和内存分页并不是对立的,它们是可以组合起来在同一个系统中使用的,那么组合起来后,通常称为**段页式内存管理**。

|

|

|

+

|

|

|

+虚拟内存地址结构就由**段号、段内页号和页内位移**三部分组成。

|

|

|

+

|

|

|

+

|

|

|

+

|

|

|

+## 缺页中断

|

|

|

+

|

|

|

+进程访问的虚拟地址在页表中查不到时,系统会产生一个**缺页异常**,进入系统内核空间分配物理内存、更新进程页表,最后再返回用户空间,恢复进程的运行。

|

|

|

+

|

|

|

+缺页中断主要分为一下两种:

|

|

|

+

|

|

|

+* **硬性页缺失(Hard Page Fault)**:物理内存中没有对应的物理页。此时MMU就会建立相应的虚拟页和物理页的映射关系。

|

|

|

+

|

|

|

+如果发生硬性页缺失,CPU会看是否有空闲的物理内存,如果有,就直接分配物理内存,并建立虚拟内存与物理内存之间的映射关系。

|

|

|

+

|

|

|

+如果物理内存中没有空闲的物理页面(有虚拟内存可以用,不会发生OOM)可用的话。操作系统就必须将物理内存中的一个物理页淘汰出去,这样就可以腾出空间来加载新的页面了。更新页表主要有一下几种算法

|

|

|

+

|

|

|

+1. **最佳页面置换算法(OPT,Optimal)**:优先选择淘汰的页面是以后永不使用的,或者是在最长时间内不再被访问的页面,这样可以保证获得最低的缺页率。但由于人们目前无法预知进程在内存下的若干页面中哪个是未来最长时间内不再被访问的,因而该算法无法实现,只是理论最优的页面置换算法,可以作为衡量其他置换算法优劣的标准。

|

|

|

+

|

|

|

+2. **先进先出页面置换算法(FIFO,First In First Out)** : 最简单的一种页面置换算法,总是淘汰最先进入内存的页面,即选择在内存中驻留时间最久的页面进行淘汰。该算法易于实现和理解,一般只需要通过一个 FIFO 队列即可需求。不过,它的性能并不是很好。

|

|

|

+

|

|

|

+3. **最近最久未使用页面置换算法(LRU ,Least Recently Used)**:LRU 算法赋予每个页面一个访问字段,用来记录一个页面自上次被访问以来所经历的时间 T,当须淘汰一个页面时,选择现有页面中其 T 值最大的,即最近最久未使用的页面予以淘汰。LRU 算法是根据各页之前的访问情况来实现,因此是易于实现的。OPT 算法是根据各页未来的访问情况来实现,因此是不可实现的。

|

|

|

+

|

|

|

+4. **最少使用页面置换算法(LFU,Least Frequently Used)** : 和 LRU 算法比较像,不过该置换算法选择的是之前一段时间内使用最少的页面作为淘汰页。

|

|

|

+

|

|

|

+* **软性页缺失(Soft Page Fault)**:物理内存中有对应的物理页,但虚拟页还未和物理页建立映射。此时MMU就会建立相应的虚拟页和物理页的映射关系。

|

|

|

+

|

|

|

+## 在 4GB 物理内存的机器上,申请 8G 内存会怎么样?

|

|

|

+

|

|

|

+- 在 32 位操作系统,因为进程理论上最大能申请 3 GB 大小的虚拟内存,所以直接申请 8G 内存,会申请失败。

|

|

|

+- 在 64位 位操作系统,因为进程理论上最大能申请 128 TB 大小的虚拟内存,即使物理内存只有 4GB,申请 8G 内存也是没问题,因为申请的内存是虚拟内存。如果这块虚拟内存被访问了,要看系统有没有 Swap 分区:

|

|

|

+ - 如果没有 Swap 分区,因为物理空间不够,进程会被操作系统杀掉,原因是 OOM(内存溢出);

|

|

|

+ - 如果有 Swap 分区,即使物理内存只有 4GB,程序也能正常使用 8GB 的内存,进程可以正常运行;

|

|

|

+

|

|

|

+## 进程和线程

|

|

|

+

|

|

|

+* **进程(Process)** 是指计算机中正在运行的一个程序实例。

|

|

|

+* **线程(Thread)** 也被称为轻量级进程,更加轻量。多个线程可以在同一个进程中同时执行,并且共享进程的资源比如内存空间、文件句柄、网络连接等。

|

|

|

+

|

|

|

+### PCB 是什么?包含哪些信息?

|

|

|

+

|

|

|

+**PCB(Process Control Block)** 即进程控制块,是操作系统中用来管理和跟踪进程的数据结构,每个进程都对应着一个独立的 PCB。你可以将 PCB 视为进程的大脑。

|

|

|

+

|

|

|

+当操作系统创建一个新进程时,会为该进程分配一个唯一的进程 ID,并且为该进程创建一个对应的进程控制块。当进程执行时,PCB 中的信息会不断变化,操作系统会根据这些信息来管理和调度进程。

|

|

|

+

|

|

|

+**进程描述信息:**

|

|

|

+

|

|

|

+- 进程标识符:标识各个进程,每个进程都有一个并且唯一的标识符;

|

|

|

+- 用户标识符:进程归属的用户,用户标识符主要为共享和保护服务;

|

|

|

+

|

|

|

+**进程控制和管理信息:**

|

|

|

+

|

|

|

+- 进程当前状态,如 new、ready、running、waiting 或 blocked 等;

|

|

|

+- 进程优先级:进程抢占 CPU 时的优先级;

|

|

|

+

|

|

|

+**资源分配清单:**

|

|

|

+

|

|

|

+- 有关内存地址空间或虚拟地址空间的信息,所打开文件的列表和所使用的 I/O 设备信息。

|

|

|

+

|

|

|

+**CPU 相关信息:**

|

|

|

+

|

|

|

+- CPU 中各个寄存器的值,当进程被切换时,CPU 的状态信息都会被保存在相应的 PCB 中,以便进程重新执行时,能从断点处继续执行。

|

|

|

+

|

|

|

+### 进程间的通信方式有哪些?

|

|

|

+

|

|

|

+1. **管道/匿名管道(Pipes)**:用于具有亲缘关系的父子进程间或者兄弟进程之间的通信。

|

|

|

+

|

|

|

+2. **信号(Signal)**:信号是一种比较复杂的通信方式,用于通知接收进程某个事件已经发生;

|

|

|

+

|

|

|

+3. **消息队列(Message Queuing)**:消息队列是消息的链表,具有特定的格式,存放在内存中并由消息队列标识符标识。管道和消息队列的通信数据都是先进先出的原则。与管道(无名管道:只存在于内存中的文件;命名管道:存在于实际的磁盘介质或者文件系统)不同的是消息队列存放在内核中,只有在内核重启(即,操作系统重启)或者显式地删除一个消息队列时,该消息队列才会被真正的删除。消息队列可以实现消息的随机查询,消息不一定要以先进先出的次序读取,也可以按消息的类型读取.比 FIFO 更有优势。**消息队列克服了信号承载信息量少,管道只能承载无格式字 节流以及缓冲区大小受限等缺点。**

|

|

|

+

|

|

|

+4. **信号量(Semaphores)**:信号量是一个计数器,用于多进程对共享数据的访问,信号量的意图在于进程间同步。这种通信方式主要用于解决与同步相关的问题并避免竞争条件。

|

|

|

+

|

|

|

+5. **共享内存(Shared memory)**:使得多个进程可以访问同一块内存空间,不同进程可以及时看到对方进程中对共享内存中数据的更新。这种方式需要依靠某种同步操作,如互斥锁和信号量等。可以说这是最有用的进程间通信方式。

|

|

|

+

|

|

|

+6. **套接字(Sockets)** : 此方法主要用于在客户端和服务器之间通过网络进行通信。套接字是支持 TCP/IP 的网络通信的基本操作单元,可以看做是不同主机之间的进程进行双向通信的端点,简单的说就是通信的两方的一种约定,用套接字中的相关函数来完成通信过程。

|

|

|

+

|

|

|

+### 进程和线程的区别

|

|

|

+

|

|

|

+- 线程是进程划分成的更小的运行单位,一个进程在其执行的过程中可以产生多个线程。

|

|

|

+- 线程和进程最大的不同在于基本上各进程是独立的,而各线程则不一定,因为同一进程中的线程极有可能会相互影响。

|

|

|

+- 线程执行开销小,但不利于资源的管理和保护;而进程正相反。

|

|

|

+

|

|

|

+### 线程的通信方式

|

|

|

+

|

|

|

+* 互斥锁

|

|

|

+* 信号量

|

|

|

+

|

|

|

+### 线程间的同步的方式有哪些?

|

|

|

+

|

|

|

+下面是几种常见的线程同步的方式:

|

|

|

+

|

|

|

+1. **互斥锁**:采用互斥对象机制,只有拥有互斥对象的线程才有访问公共资源的权限。因为互斥对象只有一个,所以可以保证公共资源不会被多个线程同时访问。

|

|

|

+2. **读写锁:允许多个线程同时读取共享资源,但只有一个线程可以对共享资源进行写操作。

|

|

|

+3. **信号量**:它允许同一时刻多个线程访问同一资源,但是需要控制同一时刻访问此资源的最大线程数量。

|

|

|

+4. **屏障**:屏障是一种同步原语,用于等待多个线程到达某个点再一起继续执行。当一个线程到达屏障时,它会停止执行并等待其他线程到达屏障,直到所有线程都到达屏障后,它们才会一起继续执行。

|

|

|

+5. **事件** :Wait/Notify:通过通知操作的方式来保持多线程同步,还可以方便的实现多线程优先级的比较操作。

|

|

|

+

|

|

|

+## 进程生命周期

|

|

|

+

|

|

|

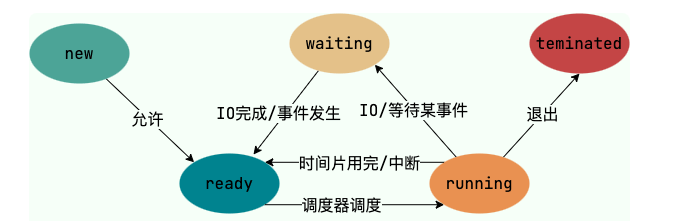

+我们一般把进程大致分为 5 种状态,这一点和线程很像!

|

|

|

+

|

|

|

+- **创建状态(new)**:进程正在被创建,尚未到就绪状态。

|

|

|

+- **就绪状态(ready)**:进程已处于准备运行状态,即进程获得了除了处理器之外的一切所需资源,一旦得到处理器资源(处理器分配的时间片)即可运行。

|

|

|

+- **运行状态(running)**:进程正在处理器上运行(单核 CPU 下任意时刻只有一个进程处于运行状态)。

|

|

|

+- **阻塞状态(waiting)**:又称为等待状态,进程正在等待某一事件而暂停运行如等待某资源为可用或等待 IO 操作完成。即使处理器空闲,该进程也不能运行。

|

|

|

+- **结束状态(terminated)**:进程正在从系统中消失。可能是进程正常结束或其他原因中断退出运行。

|

|

|

+

|

|

|

+

|

|

|

+

|

|

|

+## 死锁

|

|

|

+

|

|

|

+死锁(Deadlock)描述的是这样一种情况:多个进程/线程同时被阻塞,它们中的一个或者全部都在等待某个资源被释放。由于进程/线程被无限期地阻塞,因此程序不可能正常终止。

|

|

|

+

|

|

|

+产生死锁的四个必要条件

|

|

|

+

|

|

|

+1. **互斥**:资源必须处于非共享模式,即一次只有一个进程可以使用。如果另一进程申请该资源,那么必须等待直到该资源被释放为止。

|

|

|

+

|

|

|

+2. **占有并等待**:一个进程至少应该占有一个资源,并等待另一资源,而该资源被其他进程所占有。

|

|

|

+

|

|

|

+3. **非抢占**:资源不能被抢占。只能在持有资源的进程完成任务后,该资源才会被释放。

|

|

|

+

|

|

|

+4. **循环等待**:有一组等待进程 `{P0, P1,..., Pn}`, `P0` 等待的资源被 `P1` 占有,`P1` 等待的资源被 `P2` 占有,......,`Pn-1` 等待的资源被 `Pn` 占有,`Pn` 等待的资源被 `P0` 占有。

|

|

|

+

|

|

|

+## 如何预防死锁

|

|

|

+

|

|

|

+破坏第一个条件 **互斥条件**:使得资源是可以同时访问的,这是种简单的方法,磁盘就可以用这种方法管理,但是我们要知道,有很多资源 **往往是不能同时访问的** ,所以这种做法在大多数的场合是行不通的。

|

|

|

+

|

|

|

+破坏第三个条件 **非抢占**:也就是说可以采用 **剥夺式调度算法**,但剥夺式调度方法目前一般仅适用于 **主存资源** 和 **处理器资源** 的分配,并不适用于所有的资源,会导致 **资源利用率下降**。

|

|

|

+

|

|

|

+所以一般比较实用的 **预防死锁的方法**,是通过考虑破坏第二个条件和第四个条件。

|

|

|

+

|

|

|

+1. **静态分配策略**:一个进程必须在执行前就申请到它所需要的全部资源

|

|

|

+2. **层次分配策略**:一个进程得到某一次的一个资源后,它只能再申请较高一层的资源

|

|

|

+

|